Что такое blade сервер. Что мы знаем о серверах высокой плотности. Появление новых частей в конструкции

Пугает системных администраторов без опыта работы с этой страшной «железкой». Для многих это что-то мега сложное и дорогое, до чего еще расти и расти в профессиональном плане. Я постараюсь ответить письменно на вопросы, которые поступают от читателей сайта по поводу блейд серверов, показать, что все совсем наоборот. Конечно, все будет в разрезе виртуализации и частные случаи браться в расчет не будут. В тексте, по мере появления комплектующих, будут даваться цены на них и точные названия с парт номерами.

Для начала рассмотрим две картинки, которые будем разбирать на протяжении всего повествования. Первая, схема подключения серверов к системе хранения (SAN) и к локальной сети (LAN) с дублированием элементов системы. Постарайтесь не запутаться в проводах, как это часто бывает на практике в таких инсталляциях.

Вот так это выглядит на обычных серверах

Итак, снизу вверх. SAN – Storage Area Network – в случае виртуализации, это подключение по кабелю SAS или через оптические кабели Fiber channel (FC). Еще есть iSCSI, но это уже не SAN а NAS - Network Attached Storage. В этой статье не будем его рассматривать, т.к. iSCSI в серьезных проектах не применяется, уступая им в скорости передачи данных. И до тех пор пока 10Gibt свитчи и сетевые карты будут настролько же дороги, правильнее использовать FC (8Gbit) и SAS (6Gbit).

В системе хранения данных, обычно, два контроллера, и работают они в режиме active-active. Сначала из жестких дисков на СХД создаются RAID группы, потом в этих группах создаются логические разделы LUN-ы. Если у вас на серевере будет установлен Windows, то LUN будет отображаться как еще один жесткий диск, его нужно будет отформатировать в NTFS и пользоваться. Если же вы подключили LUN к серверу c ESXi, то он будет отформатирован в VMFS.

В режиме active-active работы контроллеров, каждому LUN присвоен свой контроллер, через который серверы подключаются к нему, таким образом происходит распределение нагрузки в СХД. Для того чтобы сервер мог подключиться к СХД и получить доступ ко всей информации в штатном режиме, его нужно соединить с каждым контроллером. Поэтому в слоты PCI-E нужно вставить два HBA адаптера, или один, но двух портовый.

Для SAS цены такие. Расчет на 3 сервера

HBA адаптер - 46M0907 - IBM 6Gb SAS HBA – 280$

- нужно 6 шт

SAS кабель 3 метра - 39R6531 - IBM 3m SAS Cable – 100$

- нужно 10 штук

SAS switch - LSI00269 - STORAGE SWITCH SAS 16P/LSI00269 LSI – 2500$

- нужно 2 шт

Для FC оптики все еще дороже. Расчет на 3 сервера

HBA адаптер - 49Y3760 - QLogic 8Gb FC Single-port HBA for IBM System x – 952$

- нужно 6 штук

FC кабель 5 метров - 39M5697 - 5m Fiber Optic Cable LC-LC – 141$

- нужно 10 шт

FC switch - 249824E - Express IBM System Storage SAN24B-4 – 3100$

- нужно 2 шт

Набор оптических трансиверов в switch - 45W0500 - SFP 8 Gbps SW – 351$

- нужно 2 шт

Трансиверы в СХД - 39R6475 - IBM 4-Gbps Optical Transceiver – SFP – 70$

- нужно 4 шт

Ну вот мы подключили серверы к СХД. Оплели всю стойку проводами и боимся подумать, как будем расширяться, если вдруг захотим еще пару серверов подключить. Особенно в случае с FC, где придется докупать дополнительные лицензии, чтобы активировать дополнительные порты в оптических свитчах. Замечу, что в если у нас одноюнитовые серверы, то там, скорее всего, два порта PCI-E и они уже заняты HBA адаптерами.

Теперь выпускаем серверы в локальную сеть (LAN), задействуем два (оба) порта для отказоустойчивости. Подключаем перекрестно к двум сетевым свитчам, добавляется еще 6 проводов. Вы спросите, почему я все время акцентирую внимание на проводах и их коммутации? Потому что в блейд сервере таких проблем нет.

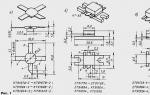

Шасси блейд сервера – это корпус высотой до 10U, в нем скрыта вся коммутация, в него нужно будет вставлять лезвия. Лезвие – это сервер в компактном корпусе, в нем все также как и в обычном сервере: 2 процессора, слоты памяти, место для двух жестких дисков размером 2.5 дюйма и в них нет вентиляторов для охлаждения, воздух гонят FAN система в шасси. Архитектура изначально построена с тем расчетом, что у вас будет система хранения, поэтому места для HDD так мало, только на установку операционной системы. Необычно выглядят карты, которые вы можете докупить в лезвия. На первой картинке FC HBA, на второй SAS HBA.

«Куда же втыкать кабель?» - спросите вы. В том и прелесть, что все подключится само и куда надо. С обратной стороны шасси есть слоты для установки всего необходимого. В первую очередь это сетевые свитчи, через которые лезвия будут соединяться с локальной сетью или глобальной. В каждом лезвии есть две встроенные сетевые карты, если вы установите с обратной стороны только один сетевой свитч, то одна карта сразу подключится к нему, а другая будет никуда не присоединена, пока не будет установлен второй свитч. Все изначально так придумано для обеспечения дублирования элементов и повышения отказоустойчивости. Получится та же схема, что и на самой первой картинке, только не будут торчать провода в разные стороны. Причем в сетевом свитче есть внутренние порты, для подключения лезвий, и внешние которые используются для коммутации с оборудованием вне корзины. Внутренние порты скрыты, но их хватит, чтобы подключить все лезвия при полном заполнении блейд шассии.

Сетевой switch для блейд шассии - 32R1860 - Nortel Networks Layer 2/3 Copper GbE Switch Module for BladeCenter – 2 186$ - нужно 2 шт.

Подключение к Блед сервер <-> СХД по SAS скорость 6Gbit/s на каждый порт

С SAS все обстоит, примерно, так же, докупаются две платы SAS HBA и два SAS switch в блейд корзину. После установки комплектующих, можно подключить систему хранения данных по SAS ко всем лезвиям. Для этого каждый контроллер СХД нужно соединить SAS кабелем с каждым SAS switch-ем блейд корзины, крест на крест. Всего 4 кабеля. В расчете на 3 сервера внутри корзины остаются 6 SAS кабелей, которые могли бы мешать нам.

SAS switch

для блейд шасси - 39Y9195 - IBM BladeCenter SAS Connectivity Module – 998$

- нужно два

SAS HBA адаптер для лезвия 2-ух портовый - 43W4068 - SAS Connectivity Card (CIOv) for IBM BladeCenter – 212$

- для трех лезвий берем 3 шт

Подключение к Блед сервер <-> СХД по FC скорость 8Gbit/s на каждый порт

FC подключение выходит сильно дороже, а методика та же, что и с SAS. Дополнительные траты могут возникнуть, если ваша система хранения не оснащена оптическими портами по умолчанию и нужно будет докупать карты расширения в нее, как это происходит с популярными IBM DS3524 и IBM DS3512. Чтобы они начали работать по оптике, докупаются еще две Daughter Card. Что касается цен, то

FC switch

в блед шассии - 44X1920 - Brocade 20-port 8 Gb SAN Switch Module for IBM BladeCenter – 13 093$

- нужно два, не дешево, да

Набор трансиверов для FC switch - 44X1962 - Brocade 8 Gb SFP+ SW Optical Transceiver – 296$

- как минимум 8шт или 12 в оба свитча

FC HBA в лезвия двух портовые - 44X1945 - QLogic 8Gb Fibre Channel Expansion Card (CIOv) for IBM BladeCenter – 1 197$

- по одной в каждое лезвие

Подводя итог , решение на блейд сервере дороже решения на обычных серверах, но оно того стоит. Вы получите очень качественный и понятный агрегат, который позволит вам легко расширять свои вычислительные мощности, просто докупая лезвия, не задумываясь о коммутации, месте в стойке, охлаждении. В сочетании с виртуализацией решение превращается в идеальное сочетание, т.к. архитектура блейд сервера и подключенного к нему СХД (или нескольких) – это как раз та схема, которая обозначается как документах по дизайну инфраструктуры, как рекомендуемая.

Поэтому если позволяет бюджет, запрашивайте коммерческие предложения, построенные на блейд серверах. При подключении СХД через SAS к корзине это уже и не так дорого получается, вполне доступно. Весь прайс лист публиковать не буду, это бессмысленно, но обозначу некоторые моменты.

Шасси стоит 5 100 $

Лезвия начинаются от 3 300$

в начальной комплектации, по цене как и обычные серверы

Система хранения без дисков 5 300$

с 4-мя встроенными SAS портами

IBM очень хорошо относится к компаниям заказчикам, которые в первый раз покупают продукцию, а особенно к тем, кто покупает решения, несомненно, блейд сервер считается решением. IBM любит конкурировать с HP и в последние годы у нее это получается. Выражается это в очень хороших скидках иногда до 30% на готовое коммерческое предложение.

P.S. тема многосторонняя, если считаете, что статью стоит чем-то дополнить, шлите пожелания на почту (справа над баннерами), я старался максимально доступно писать.

В Конспекте мы часто обходим стороной enterprise-технологии из-за их малой применимости в не столь масштабных проектах. Но сегодняшняя статья – исключение, потому что речь пойдет о модульных системах, "блейдах".

Не так много архитектурных изысков в IT-мире, которые были бы окутаны большим ореолом "невероятной крутости" и сравнимым набором мифов. Поэтому не буду усложнять еще больше, и просто расскажу об особенностях и применимости такого рода систем на практике.

LEGO для инженера

Блейд-сервер почти обычный сервер, в котором есть привычная материнская плата, оперативная память, процессоры и множество вспомогательных систем и адаптеров. Но "почти" заключается в том, что такой сервер не предназначен для автономной работы и поставляется в специальном компактном корпусе для установки в специальное шасси.

Шасси – или "корзина" – ни что иное, как большой короб с посадочными местами для серверов и дополнительных модулей. Все серверы и компоненты соединены при помощи большой коммутационной платы (Backplane) и образуют блейд-систему .

Если разобрать всю систему на составляющие, то на столе окажется следующая горка:

- Модули управления (различные вариации на тему IPMI).

Блейд-серверы (лезвия) – серверы без блоков питания, вентиляторов, сетевых разъемов и модулей управления;

Шасси – корпус и бэкплейн;

Системы питания и охлаждения для всех компонентов системы;

Коммутационные устройства для связи с внешним миром;

От обычного серверного шкафа все это добро отличается компактными размерами (обычно 6-10U) и высоким уровнем надежности, так как все компоненты могут быть зарезервированы. Здесь, кстати, кроется один из мифов: десяток лезвий не собирается в один большой сервер. Это будет просто десяток серверов с общей инфраструктурой.

К слову, у HPE есть решения, напоминающие традиционные blade-серверы – HPE Superdome . В качестве лезвий там используются процессорные модули с оперативной памятью. В таких решениях вся система действительно представляет собой один высокопроизводительный сервер.

Нюансы архитектурных решений разных производителей блейд-систем уже обсуждались на Хабре (статья хоть и старая, но в своих основах актуальная), поэтому я для иллюстрации использую блейд-систему от HPE – BladeSystem c7000 .

В роли лезвий могут выступать:

- Ленточные устройства.

Дисковые массивы – например, HPЕ StorageWorks D2200sb , в который можно установить до 12 дисков 2,5’’. Так легко и непринужденно нескольким серверам можно выдать общее DAS-хранилище;

Коммутаторы SAN для доступа к внешним системам хранения и полноценные NAS-серверы – например, HPE StorageWorks X1800sb ;

На картинке ниже изображена полностью укомплектованная система HPE BladeSystem c7000. Расположение компонентов понятно и так – обратите только внимание на секцию Interconnect modules. В каждый ряд устанавливается отказоустойчивая пара сетевых устройств или pass-thru модулей для простого проброса серверных сетевых интерфейсов наружу.

В компактное лезвие HPE ProLiant BL460c Gen8 помещается только два диска 2,5’’. Для большей красоты вместо дисков можно использовать сетевую загрузку с дисковой системы SAN или PXE.

Ниже изображена более компактная блейд-система от IBM. Общие принципы те же, хоты расположение узлов тут отличается:

Интереснее всего в блейдах, на мой взгляд, сетевая составляющая. С использованием модных конвергентных коммутаторов можно творить настоящие чудеса с внутренней сетью блейд-системы.

Немного сетевой и Enterprise магии

В качестве сетевых модулей могут выступать специальные коммутаторы Ethernet или SAS, либо умеющие и то и другое. Разумеется, в блейд-систему нельзя установить обыкновенный коммутатор, но совместимые модели производятся привычными брендами. Например "великолепной тройкой" HPE, Cisco, Brocade. В самом простом случае это будут просто модули доступа к сети, выводящие все 16 лезвий наружу через 16 портов Ethernet – HPE Pass-Thru .

Такой модуль не уменьшит количество сетевых проводов, но позволит подключиться к корпоративной LAN с минимальными вложениями. Если же вместо него использовать недорогой Cisco Catalyst 3020 с 8 портами 1GbE Ethernet и 4 портами 1GbE SFP, то к общей сети нужно будет подключить лишь несколько общих портов шасси.

Такие сетевые устройства своими возможностями не отличаются от обычных. Значительно интереснее выглядят модули HPE Virtual Connect (VC). Главная их особенность – возможность создавать несколько отдельных сетей с гибким распределением полосы пропускания LAN и SAN. Например, можно подвести к шасси 10GbE и "нарезать" из него 6 гигабитных LAN и один 4Gb SAN.

При этом VC поддерживает до четырех подключений к каждому серверу, что открывает определенные просторы для творчества и сборки кластеров. Подобные решения есть и у других производителей – нечто подобное от Lenovo называется IBM BladeCenter Virtual Fabric .

Вопреки расхожему мнению, сами по себе блейды не отличаются от обычных серверов, и никаких особых превосходств в плане виртуализации не предоставляют. Интересные возможности появляются только с использованием специальных, vendor-locked технологий, вроде VC от HPE или LPAR от Hitachi.

Несколько IPMI из одной консоли

Для настройки блейд-серверов можно использовать встроенные модули аппаратного управления BMC (iLO в случае HPE). Механизм администрирования и удаленного подключения мало отличается от обычного сервера, но сами управляющие модули Onboard Administrator (OA) могут резервировать друг друга и предоставляют единую точку входа для управления всеми устройствами в шасси.

OA могут быть со встроенной консолью KVM для подключения внешнего монитора, либо с одним лишь сетевым интерфейсом.

В общем и целом, администрирование через OA выглядит следующим образом:

Еще лучше – подключить блейд-систему к внешнему управляющему ПО вроде HPE Insight Control или сменившей ее OneView . Тогда можно настроить автоматическую установку операционной системы на новое лезвие и распределение нагрузки кластера.

К слову о надежности – блейды ломаются точно так же, как обычные серверы. Поэтому при заказе конфигурации не пренебрегайте резервированием компонентов и внимательным изучением инструкций по прошивке. Если подвисший Onboard Administrator доставит лишь неудобства администратору, то неправильное обновление прошивок всех элементов блейд-системы чревато ее неработоспособностью.

Но за всей этой магией мы совсем забыли о приземленных материях.

Нужен ли блейд в вашей компании

Высокая плотность, небольшое количество проводов, управление из одной точки – это все хорошо, но оценим и стоимость решения. Предположим, в абстрактной организации нужно запустить разом 10 одинаковых серверов. Сравним стоимость блейдов и традиционных стоечных моделей HPE ProLiant DL. Для простоты оценки не беру в расчет стоимость жестких дисков и сетевого оборудования.

Цены актуальны на 06.02.2017, источник – STSS

Разница почти в два миллиона рублей, при этом я не закладывал полную отказоустойчивость: дополнительный модуль управления и, в идеале, еще одно шасси. Плюс, лишаемся удобной сетевой коммутации из-за использования самых дешевых pass-thru модулей для простого вывода сетевых интерфейсов серверов наружу. VIrtual Connect был бы здесь более уместен, но цена…

Получается, что "в лоб" экономии не выйдет, поэтому перейдем к остальным плюсам и минусам блейдов.

Еще немного аргументов

К очевидным плюсам блейд-систем можно отнести:

- Надежность. Практически все узлы могут быть зарезервированы.

Плотность установки. Если нужно много-много серверов в одном ДЦ, блейды похожи на спасение;

Аккуратная и компактная кабельная инфраструктура за счет гибкой внутренней коммутации блейдов;

Удобство управления – всей корзиной можно управлять из одной консоли и без установки дополнительного ПО;

Легкая установка новых лезвий, пока есть место в шасси – прямо как с дисками в корзинах с горячей заменой. В теории, можно сразу при установке лезвия загружать настроенную систему по PXE и распределять ресурсы в кластере;

Но как же без минусов:

- Стоимость. Само по себе шасси стоит как три лезвия, а лезвие стоит как полноценный сервер.

Ограниченность лезвия. Если нужен сервер с четырьмя процессорами и большим количеством локальных жестких дисков (например, NMVE SSD), то установка столь крупного лезвия в четверть всей емкости шасси делает бессмысленным использование корзины высокой плотности;

Надежность. Несмотря на дублирование компонентов присутствует единая точка отказа – коммуникационная плата (бэкплейн) шасси. При сбое могут отказать все лезвия;

Невозможность разделения. Если нужно создать территориально распределенный кластер, нельзя просто вытащить и перевезти половину серверов – потребуется еще одно шасси;

Так что же выбрать

Блейды очень органично смотрятся в действительно крупных ЦОД, вроде хостинговых компаний. В таких сценариях на первое место выходит скорость масштабирования и максимальная плотность размещения оборудования – экономия на пространстве и администрировании вполне может окупить и корзину, и всякие Virtual Connect.

В остальных случаях более разумным и универсальным видится применение обычных стоечных серверов. Кроме того, широкое распространение быстрых систем виртуализации еще больше снизило популярность блейдов, так как большинство приложений можно "уплотнить" и с помощью виртуальных серверов. Что уж говорить, управлять виртуальными машинами еще удобнее, чем блейдами.

Если вам доводилось использовать блейд-системы в не самых крупных компаниях – поделитесь впечатлениями от администрирования.

Не секрет, что сегодня наблюдается устойчивый рост мощностей серверных систем. Выпускаются новые процессоры, развиваются подсистемы памяти, коммуникационные шины, системы хранения. Однако исследования показывают, что подавляющее большинство серверов реально не загружено даже наполовину. Кроме того, по разным данным до 75% современных администраторов занимаются исключительно поддержкой функционирования установленных систем. Таким образом, возникает потребность в повышении эффективности использования существующих систем.

Простое увеличение количества серверов в стойках приводит и к пропорциональному увеличению выделяемого тепла, коммуникационных кабелей, потребляемой электроэнергии и, конечно, занимает больше физического места. С одной стороны, это логично и закономерно, однако всегда хочется повысить эффективность. Блейд-серверы как раз и предлагают такую возможность. Конечно, это решение нельзя назвать кардинальным (как, например, шествие Wi-Fi за рубежом или ADSL в Москве:)), однако с указанными выше проблемами они справляются достаточно неплохо.

Итак, что представляет собой блейд-сервер? Эволюцию из набора обычных рековых серверов в блейд-сервер можно представить так: выносим в общее пользование блоки питания, систему охлаждения, добавляем коммутатор и KVM-переключатель, упрощаем возможности по установке дисков, убираем большинство разъемов расширения, значительно уменьшаем материнскую плату. В итоге мы получаем систему аналогичной мощности в заметно меньшем объеме с дополнительным бонусом в виде горячей замены всего блока.

Указанные выше действия приводят к следующим плюсам:

- уменьшение стоимости и повышение надежности системы питания и охлаждения;

- сокращение количества коммутационных проводов;

- повышение удобства управления системой;

- уменьшение занимаемого объема;

- уменьшение энергопотребления и выделяемого тепла;

- высокая масштабируемость;

- гибкость.

Конечно, как и у любого решения, здесь есть и своя цена таких переделок. Основным минусом является значительное сокращение возможностей по расширению. Например, может не получится поставить пару Ultra320 SCSI RAID-контроллеров или специальную коммуникационную плату. С другой стороны, есть большое количество задач, которые от такой потери не проиграют. Например, что касается системы хранения, то большинство дорогих решений используют внешние специализированные серверы и системы NAS/SAN. Если говорить о коммуникациях, то даже после «ужимки» остается возможность использования пары гигабитных сетевых интерфейсов и пары каналов Fibre Channel, чего более чем достаточно для большинства не специализированных применений. А на всякий случай в некоторых моделях предусмотрен один слот PCI. Стоит также отметить и ограниченность по мощности одного «лезвия» - установить более четырех процессоров в него будет сложно.

Данные плюсы и минусы позволяют определить область, в которой применение блейд-серверов будет экономически выгодно - много однотипных или похожих серверов, работа с задачами, которые допускают распараллеливание. Примерами таких областей являются: хостинг, терминальные решения, вычислительные кластеры, дата-центры.

Уже сейчас в крупных дата-центрах начинается переход от выдачи в аренду клиентам непосредственно оборудования к предоставлению определенных сервисов. Например, институтам или научным организациям часто бывает удобнее использовать для вычислений кластеры, установленные в дата-центрах. При этом может использоваться виртуализация сервисов и автоматическое переназначение роли отдельных серверов, что повысит надежность и эффективность использования оборудования. Кроме того, использование вычислительных мощностей «на стороне» позволит компаниям сократить затраты на IT-администраторов и заняться непосредственно производственной деятельностью.

Несомненно, не менее важной, чем железо, частью сервера, и особенно блейд-сервера, является управляющее программное обеспечение. Именно оно обеспечивает большинство из указанных выше преимуществ этого решения. И, конечно, каждый поставщик предлагает оригинальные программы по установке и управлению своими блейд-решениями.

Блейд-серверы на платформе Intel в настоящий момент предлагают несколько компаний. Коротко перечислим некоторые решения.

Dell PowerEdge 1855: процессоры Intel Xeon DP, до 8 ГБ памяти на лезвие, два гигабитных сетевых контроллера, U320 SCSI-контроллер, до двух SCSI-дисков, 10 лезвий в корпусе 7U, опционально Fibre Channel.

HP ProLiant BL p-Class (BL20p, BL30p, BL40p): процессоры Intel Xeon DP/MP, до 8/12 ГБ на лезвие, до 8 лезвий в корпусе 6U, 3 или 4 гигабитных адаптера, U320 SCSI-контроллер, два SCSI-диска.

IBM eServer BladeCenter: процессоры Intel Xeon DP/MP (есть модели и на Power PC), до 8/16 ГБ на одной плате, до 14 лезвий в корпусе 7U, два или четыре гигабитных адаптера, U320 SCSI-контроллер, два SCSI-диска (расширяется до четырех дисков), опционально Fibre Channel.

Intel Enterprise Blade Server: процессоры Intel Xeon DP/MP, до 4/8 ГБ памяти на каждом модуле, до 14 лезвий в корпусе 7U, 2/4 гигабитных сетевых контроллера, опционально Fibre Channel, U320 SCSI-контроллер, два 2,5" IDE-диска (опционально два SCSI-диска в дополнительном модуле).

Sun Fire B100s/B100x/B200x Blade Server: процессоры UltraSPARC Iii/Mobile Athlon XP/Xeon DP LV, 1/2/4 ГБ оперативной памяти, до 16 модулей в 3U-корпусе, 2/3/4 гигабитных сетевых адаптера, один 2,5" IDE-жесткий диск.

Кроме систем на процессорах Intel, на рынке можно встретить блейд-решения и на становящихся все популярнее процессорах AMD Opteron. Приведем краткие данные по некоторым из них.

HP ProLiant BL p-Class (BL25p/BL35p): процессоры AMD Opteron 200 серии /Opteron 200 серии Low Power, до 16/8 ГБ на лезвие, до 8/16 лезвий в корпусе 6U, четыре / два гигабитных сетевых порта и один порт на сто мегабит (для управления), два SCSI/IDE диска, опционально двухканальный FC контроллер.

Iwill H2B Blade Server: процессоры AMD Opteron 200 серии, до 16 ГБ оперативной памяти, два гигабитных сетевых контроллера, слот PCI-X, встроенные в лезвия БП, два порта InfiniBand, один IDE жесткий диск, до 10 лезвий в 8U корпусе.

NEXCOM HS 416: процессоры AMD Opteron 200 серии, до 8 ГБ оперативной памяти, два 2,5” IDE диска, два гигабитных сетевых адаптера и один на сто мегабит, слот расширения PCI - X, до 8 модулей в 4 U корпусе (есть лезвия и на Intel Xeon).

Tatung TUD -4010: процессоры AMD Opteron 200 HE серии, до 8 ГБ оперативной памяти, два гигабитных сетевых порта, два 2,5” IDE жестких диска, слот Low - profile PCI - X, до 10 лезвий в 4 U корпусе (есть лезвия и на Intel Xeon LV).

Тонкости конфигураций и реализаций блейд-серверов могут отличаться у разных компаний. Большинство из них предлагает на своих сайтах подробную информацию о конфигурировании системы под заказчика. Далее в этой статье мы рассмотрим подробнее решения, которые предлагает компания Fujitsu-Siemens Computers.

Блейд-серверы Fujitsu-Siemens PRIMERGY

Первой моделью блейд-серверов, представленных в марте 2002-го года компанией Fujitsu-Siemens, была серия BX300. В шасси размером 3U можно установить до двадцати лезвий на базе процессоров Intel Pentium III LV (одно- и двухпроцессорные конфигурации) или Pentium M. PRIMERGY BX300 позиционируется для использования в качестве Web/почтовых/кэширующих и других коммуникационных серверов, а также терминальных серверов.

В шасси BX300 предустановленны:

- два блока питания (по 1000 или 1200 Вт), в каждом установлено по 3 вентилятора;

- один модуль гигабитного коммутатора (Accton/Broadcom, конфигурация 10x downlink + 3x uplink), еще есть три свободных отсека для аналогичных коммутаторов (для полного использования 40 портов на лезвиях необходима их установка);

- семь вентиляторов.

Все эти устройства допускают горячую замену. Блок-схему шасси можно посмотреть на этой иллюстрации.

Ниже перечислено, что включают в себя возможные конфигурации «лезвий» (конфигурация по моделям процессоров дана на конец 2004-го года, ранее были доступны однопроцессорные лезвия и модели с меньшей частотой).

На базе процессоров Intel Pentium III LV:

- два процессора Pentium III LV 933 или 1000 МГц;

- чипсет ServerWorks 3.0 LE-T;

- два разъема для модулей оперативной памяти (Registered PC133, модули 256 МБ/512 МБ/1 ГБ, общий объем до 2 ГБ);

- двухканальный гигабитный сетевой контроллер на чипе Broadcom 5701;

- два отсека для 2,5" IDE-жестких дисков объемом 40 или 60 ГБ 5400 об./мин.

Вторая версия рассчитана на установку процессора Intel Pentium M:

- процессор Pentium M 1,6 или 2,0 ГГц;

- чипсет ServerWorks GC-SL/CSB6/CIOB-ES;

- два разъема для модулей оперативной памяти (DDR200, общий объем до 4 ГБ);

- встроенный видеоконтроллер на базе ATI Rage XL с 4 МБ видеопамяти;

- двухканальный гигабитный сетевой контроллер;

- IDE RAID-контроллер на чипе Promise PDC 20270;

- два отсека для 2,5" IDE-жестких дисков объемом 40 или 60 ГБ 5400 об./мин.;

- возможно подключение модуля для установки низкопрофильной PCI-карты (он будет занимать дополнительное место в шасси и имеет выход на лицевую сторону), поставляются модули Fibre Channel контроллера (один канал, 2 ГБ/с, Emulex LP9802) и одно- и двухпортового гигабитного сетевого контроллера на чипах Intel.

С лицевой стороны у каждого «лезвия» есть разъем для подключения специального кабеля, обеспечивающего два порта USB 1.1 и VGA-порт.

Итак, что касается железа, то в корпусе размером 3U мы можем получить двадцать (!) двухпроцессорных машин. Конечно, сегодня процессорами Intel Pentium III сложно кого-то заинтересовать, так что лучше рассматривать вторую версию - на процессорах Pentium M. По тестам, проведенным на нашем сайте, они легко конкурируют с десктопными Pentium 4 с частотой в полтора раза больше. По плотности решение BX300 от FSC является, пожалуй лидером среди блейд-систем - двадцать ноутбуков, даже без экранов, займут заметно больше места (если это не ASUS S200:)). Конечно, за это приходится расплачиваться медленной памятью, слабой дисковой системой и ограниченностью по расширению. Но два (или четыре) гигабитных сетевых порта и возможность поставить FC-контроллер несколько скрашивают эти недостатки.

В феврале 2004-го года компания представила новый блейд-сервер - модель PRIMERGY BX600. В корпусе формата 7U можно установить до десяти лезвий на базе Intel Xeon (один или два процессора на модуль) и до пяти лезвий с Xeon MP (четыре процессора на модуль). Блейд-серверы BX600 предназначены для использования в дата-центрах в качестве серверов приложений и баз данных, Web- и коммуникационных серверов с большой нагрузкой.

В шасси BX600 установлено:

- два блока питания (по 1200 Вт), в каждом установлено по 3 вентилятора, возможна установка дополнительно еще двух блоков питания;

- два модуля управления (порты RS232 и LAN/RJ-45);

- один модуль гигабитного коммутатора (конфигурация 10x downlink + 3x uplink), еще есть один свободный отсек для аналогичного коммутатора;

- KVM-переключатель (выходы 2 PS/2, 15 pin VGA);

- два блока вентиляторов.

Как и в BX300, все устройства допускают горячую замену. Блок-схему шасси можно посмотреть на этой иллюстрации . Дополнительно можно установить блок с внешними разъемами SCSI (два разъема HD68, прямое подключение к SCSI-контроллерам двух «лезвий»), в два дополнительных коммуникационных отсека два сквозных модуля Fibre Channel, два сквозных сетевых модуля или два гигабитных коммутатора.

Младшей моделью «лезвия» для шасси BX600 является BX620 двухпроцессорная модель на Intel Xeon DP:

- процессоры Xeon 2,8 ГГЦ/512 КБ, 3,06 ГГц/1 МБ, 3,2 ГГц/1 МБ, 3,2 ГГц/2 МБ;

- шесть слотов для памяти PC2100 registered DDR RAM, до 12 ГБ, поддержка Chipkill и hot-spare memory bank;

- два интегрированных гигабитных сетевых контроллера (Broadcom 5703);

- двухканальный Ultra320 SCSI HostRAID (Adaptec 7902W) с поддержкой RAID 0, 1, 10; первый канал подключен к встроенным жестким дискам, второй (только для лезвий 4 и 10) может быть использован с внешними накопителями (выведен на заднюю панель шасси);

- доступны два внутренних разъема для дополнительных коммуникационных плат; предлагаются: двухканальный модуль Fibre Channel и двухканальный гигабитный сетевой контроллер (оба с интерфейсом PCI-X); во всех лезвиях необходимо использовать одинаковые модули;

- если используется один жесткий диск, то доступен один слот PCI-X 64 бит/100 МГц для карт расширения (половинная длинна, полная высота); для установки предлагается двухканальный гигабитный сетевой контроллер; выход разъемов на переднюю панель сервера;

Если двух процессоров на одном «лезвии» недостаточно, то можно использовать BX660 четырехпроцессорную модель на Intel Xeon MP:

- процессоры Xeon MP 2,2 ГГц/2 МБ, 2,7 ГГц/2 МБ, 3,0 ГГц/4 МБ;

- восемь слотов для памяти PC2100 registered DDR RAM, до 16 ГБ, поддержка Chipkill и hot-spare memory bank;

- четыре гигабитных сетевых контроллера (Broadcom 5704);

- двухканальный Ultra320 SCSI HostRAID-контроллер (Adaptec 7902W) с поддержкой RAID 0, 1, 10; первый канал подключен к встроенным жестким дискам, второй (только для лезвий 3/4 и 9/10) может быть использован с внешними накопителями (выведен на заднюю панель шасси);

- два отсека для 3,5" SCSI-дисков с горячей заменой (36 ГБ, 72 ГБ, 146 ГБ, 10000/15000 об./мин.);

- доступны два внутренних разъема для дополнительных коммуникационных плат; предлагается двухканальный модуль Fibre Channel с интерфейсом PCI-X);

- встроенный видеоадаптер ATI Rage XL 8 МБ.

Дальнейшее развитие линейки BX600 «лезвие» BX620 S2, рассчитанное на использование последних моделей серверных процессоров Xeon компании Intel с поддержкой технологии EM64T, было анонсировано в декабре 2004-го года:

- процессоры Intel Xeon (Nocona), 3,0-3,6 ГГц c 1 МБ L2 и 800 МГц FSB;

- шесть разъемов для DDR2-400 DIMM, до 12 ГБ памяти, ECC, Chipkill, online spare;

- встроенный двухканальный сетевой гигабитный контроллер;

- встроенный контроллер Ultra320 SCSI с поддержкой RAID 0 и 1;

- два отсека для 3,5" SCSI-дисков с горячей заменой (36 ГБ, 72 ГБ, 146 ГБ, 10000/15000 об./мин.);

- если используется один жесткий диск, то доступен один слот PCI-X 64 бит/133 МГц для карт расширения (половинная длинна, полная высота); для установки предлагается: двухканальный гигабитный сетевой контроллер; двухканальный Ultra320 SCSI-контроллер, Ultra160 SCSI-контроллер, выход разъемов на переднюю панель сервера;

- доступен один внутренний разъем для дополнительной коммуникационной платы; предлагаются: двухканальный модуль Fibre Channel и двухканальный гигабитный сетевой контроллер (оба с интерфейсом PCI-X); во всех лезвиях необходимо использовать одинаковые модули;

- встроенный видеоадаптер ATI Radeon 7000-M 16 МБ.

В максимальной конфигурации можно получить двадцать процессоров Xeon, 120/80 ГБ оперативной памяти и 2,8/1,4 ТБ дисковой памяти в 10/20 дисках в 7U корпусе. Кроме того там будут установлены сетевые коммутаторы и KVM-переключатель. Единственным недостатком, пожалуй, является невозможность установки дополнительных плат расширения в четырехпроцессорные модули. С другой стороны для вычислительных кластеров чаще используют двухголовые узлы.

Все блейд-системы от FSC могут поставляться со следующим ПО:

- Windows Server 2003 Standard Edition/Enterprise Edition/Web Edition;

- SuSE Linux Enterprise Server/Professional Linux, Red Hat Enterprise Linux;

- CITRIX-Software W-MF, Multiuser SW MetaFrame, LoadBalancing;

- PRIMECLUSTER Clustering & Load Balancing.

Кроме того, поставляется фирменное ПО для установки и управления:

- Adaptive Services Control Center;

- RemoteView Software;

- RemoteView Diagnosis;

- RemoteDeploy;

- Terminal Server Deploy;

- Altiris Server Deployment;

- ServerStart;

- ServerView.

Возможна поставка дополнительного ПО, в частности, CA ARCserve и Vmware vPlatform.

Из поставляемого со всеми моделями блейд-серверов программного обеспечения отметим два приложения. RemoteDeploy с использованием заранее подготовленных образов ОС с предустановленными приложениями позволяет кардинально сократить время на подключение новых лезвий в пул. Кроме того, возможно быстрое изменение роли сервера путем перезаписи нового образа. Adaptive Services Control Center позволяет автоматически менять роль отдельных блейд-серверов в составе пула по правилам, установленным администраторами. Например, если повышается нагрузка на веб-сервер, то можно «отнять» мощность от, скажем, почтового сервера. А если нагрузка в вычислительном кластере не велика, то можно просто выключить некоторые узлы. Также эта технология позволяет выровнять нагрузку в случае отказа оборудования.

Указанные выше возможности: виртуализация (системы собраны в пулы и доступны для общего использования в любой роли), автоматизация (вычислительные ресурсы автоматически используются для обеспечения необходимых сервисов по заданным правилам), интеграция (все части компьютерных систем (вычислительные блоки, накопители, сетевое оборудование) работают и управляются совместно) компания FSC объединила в своей стратегии TRIOLE, направленной на разработку продуктов и решений для динамично развивающихся центров обработки данных. Одним из первых шагов в этом направлении и является развитие линейки блейд-серверов.

Одним из вариантов законченной системы на базе блейд-серверов PRIMERGY является FlexFrame для mySAP. Важным отличием новой версии ПО от SAP является модульная гетерогенная структура, поэтому ранее использованная модель с одним сервером не очень подходит для mySAP. Кроме того, требования к отказоустойчивости и масштабируемости при применении «классического» дизайна системы приводят к существенным затратам. FlexFrame был разработан совместно компаниями SAP, Fujitsu-Siemens Computers и NetApp и представляет собой первое решение в рамках концепции «Adaptive Computing». FlexFrame представляет собой гибкое и эффективное решение:

- каждый сервис mySAP может работать на любом лезвии;

- необходимые сервисы автоматически включаются в работу по запросу системы администрирования;

- время на установку и запуск нового лезвия составляет всего несколько минут;

- се ПО размещается в центральном хранилище и загружается по сети.

Отметим и важный для крупных клиентов момент система FlexFrame сертифицирована SAP.

Совместно с компанией versionapp FSC предлагает и решение для ферм терминальных серверов. Оно отличается большой скоростью развертывания - для полной установки системы из 220 лезвий требуется всего четыре часа. При этом весь процесс проходит в автоматическом режиме и включает в себя установку ОС, Citrix Metaframe и пользовательских аккаунтов и приложений.

Среди клиентов FSC, установивших у себя системы на базе блейд-серверов компании, есть крупные банки, телекоммуникационные компании и министерства. При этом количество лезвий в одной установке достигает 1600.

Попробуем сравнить решение на шасси BX600 с классическим. Поскольку дисковую систему лучше иметь отдельную, то добавим, например, 2 ТБ файлер FAS200 от NetApp, занимающий 3U. В сумме на 10U мы получаем 10 двухпроцессорных или 5 четырехпроцессорных систем. Если собирать аналогичную по мощности систему на обычных рековых моделях, то придется использовать 1U на каждый двухпроцессорный сервер или 2U на четырехпроцессорный. Итого у нас получается равенство по объему (мелочи типа сетевого или FC-коммутатора не учитываем).

Оба варианта имеют как свои плюсы, так и минусы. По вычислительной мощности они равны. Надежность тоже практически не отличается. Уровень шума и тепла в обоих случаях такой, что лучше рядом не находиться. Правильно построенная система управления позволит легко работать с любым из них. Причем на обычном железе можно при желании реализовать все возможности блейд-серверов, поскольку они в большинстве своем организованы программно. Хотя, конечно, замена вышедшего из строя лезвия выглядит красиво и выполняется заметно быстрее выкручивания 1U-сервера. Кроме того, в варианте «блейд» будет меньше проводов и выше порядок с обратной стороны шкафа, однако использование внешнего сетевого коммутатора добавляет гибкости классическому решению. Продолжать можно бесконечно. Кстати, не следует забывать, что обычные 1U решения тоже не сильно богаты возможностями расширения. Обычно это один или два процессора, до 8 ГБ памяти, четыре жестких диска, два гигабитных сетевых контроллера и один или два слота расширения. В любом случае под каждую конкретную задачу нужно все хорошо и тщательно считать.

Прогнозы

В настоящее время рынок блейд-серверов неспешно развивается - выходят новые модели лезвий, обновляется как железная, так и программная часть. Однако строить оптимистические прогнозы мешает следующий факт. Несмотря на то, что, с одной стороны, решения на базе блейд-северов по многим параметрам не уступают классическим решениям (например, по мощности, масштабируемости, управляемости, надежности) и даже часто уникальны, с другой стороны, именно особенности архитектуры приводят к тому, что на блейд-серверы часто смотрят с опаской, как на нарушителя установившихся традиций. Еще одна причина - в относительно большой стоимости внедрения систем. Если расширение IT-системы компании обычно производится установкой дополнительных компьютеров, то шасси даже с небольшим количеством установленных лезвий может стоить дороже отдельных серверов аналогичной мощности, особенно если решение предполагает использование нетривиальной системы хранения данных. Возможно, играет роль и «виртуальная» боязнь привязки к одному поставщику, поскольку система требует значительных вложений и не всегда легко интегрируется в существующий парк ПО и оборудования. С этим проблемами может помочь четкое планирование развития IT-структуры компании и выбор правильного поставщика.

Отрицательную роль в развитии рынка блейд-решений играет и отсутствие открытых стандартов для аппаратного дизайна шасси (и это несмотря на то, что часто решения от разных компаний являются, по сути, небольшими вариациями одного дизайна, что можно было увидеть, например, на последнем московском форуме IDF). С ПО ситуация немного проще, поскольку современные лезвия созданы на базе стандартного оборудования и при желании можно все реализовать с использованием популярного ПО. Хотя, конечно, в этом случае не все возможности лезвий будут использованы. Так что, к сожалению, несмотря на оптимистичные прогнозы IDC (рост поставок блейд-серверов в регионе EMEA на 80% с 2004-го на 2005-й год), популярность IBM PC в ближайшее время блейд-серверам не грозит:). Однако крупным заказчикам, и особенно участникам набирающего обороты рынка дата-центров, есть смысл обратить внимание на блейд-серверы и как следует все подсчитать.

С компонентами, вынесенными и обобщёнными в корзине для уменьшения занимаемого пространства. Корзина - шасси для блейд-серверов, предоставляющая им доступ к общим компонентам, например, блокам питания и сетевым контроллерам. Блейд-серверы называют также ультракомпактными серверами .

Внутренняя структура

В блейд-сервере отсутствуют или вынесены наружу некоторые типичные компоненты, традиционно присутствующие в компьютере . Функции питания, охлаждения, сетевого подключения, подключения жёстких дисков , межсерверных соединений и управления могут быть возложены на внешние агрегаты. Вместе с ними набор серверов образует так называемую блейд-систему.

Обязательно должны быть размещены в блейд серверы процессор и оперативная память, остальные компоненты принципиально могут быть вынесены в корзину; концепция блейд-сервера предусматривает замену части остальных компонентов внешними агрегатами (блоки питания) или их виртуализацию (порты ввода-вывода, консоли управления), тем самым значительно упрощая и облегчая сам сервер.

Внешние подключаемые блоки

Блейд-системы состоят из набора блейд-серверов и внешних компонентов, обеспечивающих невычислительные функции. Как правило, за пределы серверной материнской платы выносят компоненты, создающие много тепла, занимающие много места, а также повторяющиеся по функциям между серверами. Их ресурсы могут быть распределены между всем набором серверов. Деление на встроенные и внешние функции варьируется у разных производителей.

Источники питания

Преобразователь напряжения питания, как правило, создается общим для всей блейд-системы. Он может быть как вмонтирован внутрь неё, так и вынесен в отдельный блок. По сравнению с суммой отдельных блоков питания, необходимых серверам формата , единый источник питания блейд-систем - один из самых весомых источников экономии пространства, энергопотребления и числа электронных компонентов.

Охлаждение

Традиционный дизайн серверов пытается сбалансировать плотность размещения электронных компонентов и возможность циркуляции охлаждающего воздуха между ними. В блейд-конструкциях количество выступающих и крупных частей сведено к минимуму, что улучшает охлаждение модулей.

Сетевые подключения

Современные сетевые интерфейсы рассчитаны на чрезвычайно большие скорости передачи данных через токопроводящие и оптические кабели. Такая аппаратура дорога́ и занимает место в конструкции сервера. Частый случай - чрезмерная пропускная способность сетевых интерфейсов, чьи возможности оказываются не востребованы в практических задачах. Объединение сетевых интерфейсов в одно устройство или использование специальных блейд-слотов, занятых исключительно работой с сетью, позволяет сократить количество разъемов и снизить стоимость каждого из подключений.

Использование дисковых накопителей

Хотя для хранения объёмов данных и программ необходимы значительные ёмкости, им не обязательно размещаться локально. Такие интерфейсы, как FireWire , SATA , SCSI , DAS , Fibre Channel и iSCSI позволяют подсоединять накопители на значительном удалении от процессоров. По аналогии с сетевыми подключениями (а интерфейс iSCSI опирается только на них) соответствующие устройства могут быть размещены в корпусе блейд-системы или смонтированы на выделенных блейд-слотах.

Специальное решение в виде блейд-системы, загружаемой через сеть хранения данных (SAN), позволяет создать исключительно надежную и компактную серверную систему.

Специализированные блейд-слоты

Стандартизация интерфейса блейд-слота позволяет создавать устройства, способные не только производить вычисления, но и предоставлять другие сервисы, например, функции сетевого коммутатора, роутера, быстрого подключения к локальной сети или оптоволокну. Эти ресурсы могут использоваться другими блейд-слотами.

Области применения

В стандартных серверных стойках минимальный размер сервера - 1 юнит , как правило, такие стойки вмещают 42 юнита оборудования, то есть максимум 42 сервера при размещении без корзин. Использование блейд-серверов позволяет обойти это ограничение не выходя за размеры стандартной стойки и разместить до 100 серверов в каждой.

Блейд-серверы особенно эффективны для решения специфических задач: веб-хостинга , организации кластеров . Серверы в стойке, как правило, поддерживают горячую замену .

Хотя технология построения блейд-систем не является закрытой (принадлежащей какой-то одной компании), при использовании компонентов одного производителя возникает меньше проблем с инсталляцией и настройкой. Стандартизация сопряжений могла бы сделать технологию доступнее для пользователя и расширить выбор поставщиков.

При всех достоинствах, эту технологию нельзя считать решением всех серверных проблем. Крупные задачи требуют все же применения более масштабных систем для своего решения, таких как мейнфреймы и кластеры . Также могут быть использованы кластеры, состоящие из блейд-серверов. Такая структура особенно подвержена проблеме перегрева ввиду плотной компоновки электроники в каждом из них.

История создания

Микрокомпьютеры, умещавшиеся в 1 слот стандартной 19-дюймовой стойки, стали использовать ещё в 1970-е годы, вскоре после разработки 8-битных микропроцессоров. Наборы таких слотов использовали в управлении промышленными объектами, заменяя мини-компьютеры. Программы записывались в электрически программируемую память (EPROM) на слоте, их функциональность ограничивалась одной несложной операцией, выполняемой в реальном времени .

Название «блейд-сервер» стало применяться по отношению к системам с установленными жёсткими дисками или флеш-памятью . Благодаря этому появилась возможность исполнять на слоте полноценную операционную систему .

Технология заимствует некоторые черты мейнфреймов . Однако, корректнее рассматривать группу блейд-слотов как кластер независимых серверов, возможно и активное использование виртуализации ресурсов и тесной интеграции с операционной системой, что дополнительно увеличивает производительность и стабильность.

Первым производителем блейд-систем считается RLX Technologies (Хьюстон , США), основанная выходцами из компании Compaq . Компания была куплена Hewlett-Packard в 2005 году.

По состоянию на вторую половину 2000-х годов лидером в производстве блейд-систем являлась компания Hewlett-Packard , доля которой за 2008 год на международном рынке по выручке от продаж и количеству произведённых и поставленных единиц оборудования составила соответственно 54,0 % и 50,6 %, что вдвое больше доли компании № 2, IBM (23,9 % и 25,9 %). Другие крупные участники рынка: Dell (доли на мировом рынке 8,1 % и 9,5 % соответственно), Fujitsu Siemens Computers (3,5 % и 2,1 %), Sun (4,1 % и 4,0 %), Hitachi (1,0 % и 0,6 %) и NEC (1,6 % / 1,2 %).

Блейд-серверы производят с различным успехом и другие компании, например Appro , Intel , Rackable (SGI), Verari , Supermicro , однако они занимают на рынке блейд-серверов долю в несколько десятых процента или даже менее.

Напишите отзыв о статье "Блейд-сервер"

Ссылки

См. также

Отрывок, характеризующий Блейд-сервер

Гостиная Анны Павловны начала понемногу наполняться. Приехала высшая знать Петербурга, люди самые разнородные по возрастам и характерам, но одинаковые по обществу, в каком все жили; приехала дочь князя Василия, красавица Элен, заехавшая за отцом, чтобы с ним вместе ехать на праздник посланника. Она была в шифре и бальном платье. Приехала и известная, как la femme la plus seduisante de Petersbourg [самая обворожительная женщина в Петербурге,], молодая, маленькая княгиня Болконская, прошлую зиму вышедшая замуж и теперь не выезжавшая в большой свет по причине своей беременности, но ездившая еще на небольшие вечера. Приехал князь Ипполит, сын князя Василия, с Мортемаром, которого он представил; приехал и аббат Морио и многие другие.

– Вы не видали еще? или: – вы не знакомы с ma tante [с моей тетушкой]? – говорила Анна Павловна приезжавшим гостям и весьма серьезно подводила их к маленькой старушке в высоких бантах, выплывшей из другой комнаты, как скоро стали приезжать гости, называла их по имени, медленно переводя глаза с гостя на ma tante [тетушку], и потом отходила.

Все гости совершали обряд приветствования никому неизвестной, никому неинтересной и ненужной тетушки. Анна Павловна с грустным, торжественным участием следила за их приветствиями, молчаливо одобряя их. Ma tante каждому говорила в одних и тех же выражениях о его здоровье, о своем здоровье и о здоровье ее величества, которое нынче было, слава Богу, лучше. Все подходившие, из приличия не выказывая поспешности, с чувством облегчения исполненной тяжелой обязанности отходили от старушки, чтобы уж весь вечер ни разу не подойти к ней.

Молодая княгиня Болконская приехала с работой в шитом золотом бархатном мешке. Ее хорошенькая, с чуть черневшимися усиками верхняя губка была коротка по зубам, но тем милее она открывалась и тем еще милее вытягивалась иногда и опускалась на нижнюю. Как это всегда бывает у вполне привлекательных женщин, недостаток ее – короткость губы и полуоткрытый рот – казались ее особенною, собственно ее красотой. Всем было весело смотреть на эту, полную здоровья и живости, хорошенькую будущую мать, так легко переносившую свое положение. Старикам и скучающим, мрачным молодым людям, смотревшим на нее, казалось, что они сами делаются похожи на нее, побыв и поговорив несколько времени с ней. Кто говорил с ней и видел при каждом слове ее светлую улыбочку и блестящие белые зубы, которые виднелись беспрестанно, тот думал, что он особенно нынче любезен. И это думал каждый.

Маленькая княгиня, переваливаясь, маленькими быстрыми шажками обошла стол с рабочею сумочкою на руке и, весело оправляя платье, села на диван, около серебряного самовара, как будто всё, что она ни делала, было part de plaisir [развлечением] для нее и для всех ее окружавших.

– J"ai apporte mon ouvrage [Я захватила работу], – сказала она, развертывая свой ридикюль и обращаясь ко всем вместе.

– Смотрите, Annette, ne me jouez pas un mauvais tour, – обратилась она к хозяйке. – Vous m"avez ecrit, que c"etait une toute petite soiree; voyez, comme je suis attifee. [Не сыграйте со мной дурной шутки; вы мне писали, что у вас совсем маленький вечер. Видите, как я одета дурно.]

И она развела руками, чтобы показать свое, в кружевах, серенькое изящное платье, немного ниже грудей опоясанное широкою лентой.

– Soyez tranquille, Lise, vous serez toujours la plus jolie [Будьте спокойны, вы всё будете лучше всех], – отвечала Анна Павловна.

– Vous savez, mon mari m"abandonne, – продолжала она тем же тоном, обращаясь к генералу, – il va se faire tuer. Dites moi, pourquoi cette vilaine guerre, [Вы знаете, мой муж покидает меня. Идет на смерть. Скажите, зачем эта гадкая война,] – сказала она князю Василию и, не дожидаясь ответа, обратилась к дочери князя Василия, к красивой Элен.

– Quelle delicieuse personne, que cette petite princesse! [Что за прелестная особа эта маленькая княгиня!] – сказал князь Василий тихо Анне Павловне.

Вскоре после маленькой княгини вошел массивный, толстый молодой человек с стриженою головой, в очках, светлых панталонах по тогдашней моде, с высоким жабо и в коричневом фраке. Этот толстый молодой человек был незаконный сын знаменитого Екатерининского вельможи, графа Безухого, умиравшего теперь в Москве. Он нигде не служил еще, только что приехал из за границы, где он воспитывался, и был в первый раз в обществе. Анна Павловна приветствовала его поклоном, относящимся к людям самой низшей иерархии в ее салоне. Но, несмотря на это низшее по своему сорту приветствие, при виде вошедшего Пьера в лице Анны Павловны изобразилось беспокойство и страх, подобный тому, который выражается при виде чего нибудь слишком огромного и несвойственного месту. Хотя, действительно, Пьер был несколько больше других мужчин в комнате, но этот страх мог относиться только к тому умному и вместе робкому, наблюдательному и естественному взгляду, отличавшему его от всех в этой гостиной.

– C"est bien aimable a vous, monsieur Pierre , d"etre venu voir une pauvre malade, [Очень любезно с вашей стороны, Пьер, что вы пришли навестить бедную больную,] – сказала ему Анна Павловна, испуганно переглядываясь с тетушкой, к которой она подводила его. Пьер пробурлил что то непонятное и продолжал отыскивать что то глазами. Он радостно, весело улыбнулся, кланяясь маленькой княгине, как близкой знакомой, и подошел к тетушке. Страх Анны Павловны был не напрасен, потому что Пьер, не дослушав речи тетушки о здоровье ее величества, отошел от нее. Анна Павловна испуганно остановила его словами:

– Вы не знаете аббата Морио? он очень интересный человек… – сказала она.

– Да, я слышал про его план вечного мира, и это очень интересно, но едва ли возможно…

– Вы думаете?… – сказала Анна Павловна, чтобы сказать что нибудь и вновь обратиться к своим занятиям хозяйки дома, но Пьер сделал обратную неучтивость. Прежде он, не дослушав слов собеседницы, ушел; теперь он остановил своим разговором собеседницу, которой нужно было от него уйти. Он, нагнув голову и расставив большие ноги, стал доказывать Анне Павловне, почему он полагал, что план аббата был химера.

– Мы после поговорим, – сказала Анна Павловна, улыбаясь.

И, отделавшись от молодого человека, не умеющего жить, она возвратилась к своим занятиям хозяйки дома и продолжала прислушиваться и приглядываться, готовая подать помощь на тот пункт, где ослабевал разговор. Как хозяин прядильной мастерской, посадив работников по местам, прохаживается по заведению, замечая неподвижность или непривычный, скрипящий, слишком громкий звук веретена, торопливо идет, сдерживает или пускает его в надлежащий ход, так и Анна Павловна, прохаживаясь по своей гостиной, подходила к замолкнувшему или слишком много говорившему кружку и одним словом или перемещением опять заводила равномерную, приличную разговорную машину. Но среди этих забот всё виден был в ней особенный страх за Пьера. Она заботливо поглядывала на него в то время, как он подошел послушать то, что говорилось около Мортемара, и отошел к другому кружку, где говорил аббат. Для Пьера, воспитанного за границей, этот вечер Анны Павловны был первый, который он видел в России. Он знал, что тут собрана вся интеллигенция Петербурга, и у него, как у ребенка в игрушечной лавке, разбегались глаза. Он всё боялся пропустить умные разговоры, которые он может услыхать. Глядя на уверенные и изящные выражения лиц, собранных здесь, он всё ждал чего нибудь особенно умного. Наконец, он подошел к Морио. Разговор показался ему интересен, и он остановился, ожидая случая высказать свои мысли, как это любят молодые люди.

В настоящее время существует большой класс задач, требующих высокой концентрации вычислительных средств. К ним могут относиться как сложные ресурсоемкие вычисления (научные задачи, математическое моделирование, вычислительный поиск), так и обслуживание большого числа пользователей (распределенные базы данных, Интернет-сервисы и хостинг, серверы приложений).

Мощность вычислительного центра можно сделать больше, увеличив производительность отдельных вычислительных модулей или их количество. В настоящее время преобладает вторая тенденция, и усилия разработчиков направлены, прежде всего, на внедрение параллельных вычислений.

Это связано с тем, что поскольку сейчас производительность центрального процессора очень высока при относительно низкой стоимости, рациональнее использовать для решения большинства задач кластерные конфигурации, а не сложные многопроцессорные системы. В будущем, скорее всего, эта тенденция сохранится (надеяться на это позволяет появление многоядерных центральных процессоров, еще более сокращающих разрыв в вычислительной мощности между специализированными решениями и простыми серверами с двумя — четырьмя центральными процессорами).

Увеличение числа вычислительных модулей в вычислительном центре требует новых подходов к размещению серверов. Применение кластерных решений приводит к росту затрат на помещения для центров обработки данных, их охлаждение и обслуживание.

Решить некоторые из этих проблем поможет новый тип серверов - модульные, чаще называемые Blade-серверами, или серверами-лезвиями (blade - лезвие). Набирающие популярность Blade-серверы - это воистину серверы XXI века (их первые модели были разработаны в 2001 г.), преимущества которых изготовители описывают с помощью правила «1234». Оно звучит так: по сравнению с обычными серверами при сравнимой производительности Blade-серверы занимают в два раза меньше места, потребляют в три раза меньше энергии и обходятся в четыре раза дешевле.

Итак, что представляет собой Blade-сервер? Прежде всего стоит привести определение IDC: аналитическая компания называет лезвием (Blade-сервером) модульную одноплатную компьютерную систему, включающую процессор и память. Лезвия вставляются в специальное шасси (или полку) с объединительной панелью (backplane), обеспечивающей им подключение к сети и подачу электропитания. Это шасси с лезвиями, по мнению IDC, является Blade-системой. Оно выполнено в конструктиве для установки в стандартную 19-дюймовую стойку и в зависимости от модели и производителя, занимает в ней 3U, 6U или 10U (один U - unit, или монтажная единица, равен 1,75 дюйма). За счет общего использования таких компонентов, как источники питания, сетевые карты и жесткие диски, Blade-серверы обеспечивают более высокую плотность размещения вычислительной мощности в стойке по сравнению с обычными тонкими серверами высотой 1U и 2U, такими как dell pe r210 или dell pe r410.

Фактически блейд система состоит из следующих компонентов

- Blade-серверы (фактически это обычные серверы без блока питания, с пассивными радиаторами и без PCI разьемов - убраны все «лишние компоненты»)

- Корпус и пассивный Backplane (плата обеспечивающая коммутацию установленного оборудования)

- Системы питания и охлаждения (вентиляторы блоки питания)

- Внешние коммутационные устройства(Ethernet, FC, Infiniband)

Вместо обычных PCI(PCI-E, PCI-X) плат в сервер вставляются мезонинные карты, которые позволяют использовать интерфейсы FC, Infiniband, SAS, или дополнительные порты Ethernet, при наличии в шасси соответствующего внешнего коммутационного модуля.

Типичный Blade сервер: нет ни блока питания, ни вентиляторов - ничего лишнего!

Тем не менее, по данным аналитиков, повышенная плотность лезвий сейчас отходит на второй план и их главным преимуществом для корпоративного сектора становится улучшение управляемости серверов с более высокой степенью автоматизации их обслуживания. Переход к серверной инфраструктуре, построенной из лезвий, позволяет реализовать интегрированное управление системы и отойти от прежней схемы работы Intel-серверов, когда каждому приложению выделялась отдельная машина. На практике это означает значительно более рациональное использование серверных ресурсов, уменьшение числа рутинных процедур (таких, как подключение кабелей), которые должен выполнять системный администратор, и экономию его рабочего времени.

Типичное 10U шасси для 10 Blade-серверов

Кроме того, Blade-серверы намного проще обслуживать, чем обычные стоечные серверы, - например, при выходе машины из строя системный администратор просто заменяет лезвие на новое и затем в дистанционном режиме инсталлирует на него ОС и прикладное ПО. В настоящее время разработчики пакетов для управления Blade-серверами реализуют в своих продуктах не только возможности автоматического развертывания на новых серверах ОС и приложений, но и функции быстрого обновления установленного ПО или инсталляции программных “заплаток”.

Blade-серверы являются крайне эффективным решением для экономии пространства в центрах обработки данных (ЦОД), а также с точки зрения их консолидации и перехода к централизованному управлению серверным парком. Например, системный администратор может управлять шасси с лезвиями как одним объектом и по мере роста нагрузок увеличивать его вычислительную мощность, добавляя новые лезвия. Кроме того, поскольку обычно в шасси предусмотрена возможность установки сетевых коммутаторов, эта опция позволяет провести и консолидацию сетевых ресурсов ЦОД.

Помимо уменьшения занимаемой площади в ЦОД, экономический эффект от перехода на лезвия имеет еще несколько составляющих. Поскольку в них входит меньше компонентов, чем в обычные стоечные серверы, и они часто используют низковольтные модели процессоров, то сокращаются требования к энергообеспечению и охлаждению машин. Как уже говорилось выше, экономится рабочее время администратора, который в результате успевает обслуживать больше объектов, и поэтому при росте серверного парка, предприятию не обязательно нанимать еще одного администратора. Наконец, хотя при переходе к архитектуре Blade-серверов вместе с самими лезвиями нужно приобретать и шасси, благодаря совместному использованию его компонентов дальнейшее масштабирование Blade-системы требует меньше затрат, чем системы из стоечных серверов, и шасси с пятью - десятью лезвиями обходится дешевле аналогичного числа обычных стоечных машин.

Преимущества использования Blade-серверов можно выразить следующим списком:

- уменьшение стоимости и повышение надежности системы питания и охлаждения;

- сокращение количества коммутационных проводов;

- повышение удобства управления системой;

- уменьшение занимаемого объема;

- уменьшение энергопотребления и выделяемого тепла;

- высокая масштабируемость;

- гибкость.

Разумеется «Blade» имеют и недостатки:

- отсутствие общего стандарта и общей платформы. Для пользователей это выражается в невозможности установить, например, Blade-сервер SUN в шасси IBM;

- одна точка отказа в большинстве Blade-систем: само шасси - это точка отказа системы. Если шасси отказывает, то простаивают все установленные в него «лезвия», что, несомненно, наносит значительный урон бизнесу их владельца. Однако, надо понимать, что само шасси (корпус и backplane) это пассивный компонент повредить который можно лишь только физически;

- «Blade» неэффективны для решения задач, требующих малого числа серверов (например, двух или трех). В этом случае выгоднее использовать обычные серверы, не переплачивая за шасси;

- ограниченный класс приложений, выполняемых «Blade`ами»: поскольку Blade-серверы комплектуются одним или двумя процессорами, задачи, оптимизированные для традиционных серверов с большим числом процессоров, сложно переносить на «Blade»;

- плохие возможности внутренней расширяемости Blade-серверов: отсутствие возможности устанавливать платы расширения в серверы (возможность установить одну низкопрофильную PCI –плату в некоторых моделях), малые объёмы оперативной памяти.

- ограниченный размер внутренней дисковой подсистемы – сервер как правило имеет разъем под 2 жестких диска 2,5. Это связано с тем, блейд серверы применяются под задачи виртуализации и подразумевается использование внешнего массива.

В целом, внедрение Blade-серверов приносит больше положительного эффекта, оно экономически выгодно. Однако, традиционно, введению новшества сопротивляется человек. Большинство компаний опасается приобретать Blade-системы, предпочитая проверенные временем стоечные или башенные серверы. Но с каждым годом объём продаж Blade-серверов растёт, появляется всё больше решений на их основе.

Чем Blade-серверы отличаются от привычных стоечных серверов?

Физическая конструкция. Многие преимущества Blade систем обеспечивает уникальная физическая конструкция. Совместное использование таких ресурсов, как средства питания, охлаждения, коммутации и управления, снижает сложность и ликвидирует проблемы, которые характерны для более традиционных серверных инфраструктур. Физическая конструкция Blade систем предполагает размещение Blade-серверов в специальном шасси (полке) и основным ее конструктивным элементом является объединительная панель.

Объединительная панель разработана таким образом, что она решает все задачи коммутации Blade-серверов с внешним миром: подача питания, подключения к сетям Ethernet, сетям Fiber Channel а также обеспечивает взаимодействие по протоколу SAS (SCSI) с системами хранения в том же шасси (дополнительные диски или ленты). Шасси для Blade`ов также позволяет размещать в нем необходимые коммутаторы Ethernet или Fibre Channel для связи с внешними сетями. Выход на эти коммутаторы из Blade-серверов обеспечивают предустановленные или устанавливаемые дополнительно контроллеры Ethernet или Fibre Channel.

Меньшее количество кабелей. Средства коммутации во внешние сети, интегрированные в общую полку значительно сокращают количество кабелей. Новой системе HP BladeSystem требуется на 94% меньше кабелей для подключения к ЛВС и SAN, чем традиционным стоечным серверам. В шасси могут быть вставлены коммутаторы, которые обеспечивают взаимодействие как внутри шасси, так и с внешними устройствами.

Если вы думаете, что здесь много кабелей - вы ошибаетесь

Общие средства питания и охлаждения. Размещение систем питания и охлаждения в общей полке, а не в отдельных серверах, обеспечивает снижение энергопотребления и повышение надежности. Кроме того, благодаря новым и более интеллектуальным функциям, снижается потребление энергии. Например для Blade-серверов HP новые технологии охлаждения HP Thermal Logic общее потребление энергии снижается более, чем на 30 % по сравнению со стоечными системами, и для охлаждения всего решения требуется меньше электроэнергии и воздуха. В основном, это достигается тем, что используются более мощные блоки питания и вентиляторы, общие для всего шасси.

Лучшие возможности управления. Blade-серверы принципиально отличаются от стоечных серверов, таких как dell pe r510, тем, что серверная полка имеет интеллект в виде модулей управления. Для Blade систем HP функции интеллектуального управления выполняет специальный модуль Onboard Administrator, который отсутствует в стойках при размещении традиционных серверов. Помимо IP KVM присутствуют средства мониторинга и управления питанием, коммутационными модулями и средства быстрого развертывания системы.

Лёгкое администрирование любого Blade сервера в шасси

Не требуется клавиатура, видео и мышь. Управление новой системой HP BladeSystem осуществляется с помощью централизованного модуля Onboard Administrator и процессора удаленного управления iLO2 на каждом Blade-сервере, поэтому не требуются отдельные кабели и коммутаторы для клавиатуры, видео и мыши (KVM).

Размер и плотность. Серверы и инфраструктурные элементы в составе HP BladeSystem имеют меньший размер и занимают меньше места, чем аналогичные стоечные решения, что помогает экономить электроэнергию и пространство, выделенное для ИТ. Кроме того, благодаря модульной архитектуре, они являются более удобными во внедрении и обслуживании.

Основное преимущество Blade-серверов - повышенная плотность размещения

Повышенная надежность. В традиционных стоечных средах для повышения надежности устанавливается дополнительное оборудование, средства коммутации и сетевые компоненты, обеспечивающие резервирование, что влечет за собой дополнительные расходы. Например, HP BladeSystem имеет встроенные средства резервирования, причем конфигурации резервирования N+1 более удобны в настройке и экономичны по сравнению с полным дублированием.

Снижение эксплуатационных расходов. Инфраструктура Blade систем является более простой в управлении, чем традиционные ИТ- инфраструктуры на стоечных серверах. В некоторых случаях системы HP BladeSystem позволили компаниям увеличить количество ресурсов под управлением одного администратора (серверы, коммутаторы и системы хранения) более чем в два раза. На основании средних показателей время развертывания одного стоечного сервера ProLiant DL360 составляет 4 часа, а Blade-сервера ProLiant BL460c - 30 минут. После инсталляции серверной полки, добавление нового Blade-сервера выполняется значительно быстрее, чем процедура установки стоечного сервера, которая включает в себя монтаж сервера в стойку, прокладку кабелей, установку операционной системы, настройку подключений к ЛВС и системам хранения. Любые изменения также выполняются быстрее. Управляющее программное обеспечение HP Insight Control помогает ИТ-организациям экономить время благодаря возможности эффективного развертывания, мониторинга и контроля за инфраструктурой HP BladeSystem. Благодаря автоматизации основных ИТ-процессов оно позволяет сотрудникам концентрировать свое внимание на более важных задачах и действовать проактивно.

Эволюция Blade-серверов

Первой компанией, начавшей производство Blade-серверов, была RLX Technologies. Поскольку RLX - родоначальница Blade-серверов, их история неразрывно связана с развитием модельного ряда фирмы. Остановимся подробнее на истории развития Blade-серверов, выпускаемых компанией RLX Technologies.

Первый Blade- сервер RLX ServerBlade 633

В мае 2001 г. появился Blade-сервер первого поколения - ServerBlade 633. Для уменьшения количества выделяемого тепла инженеры RLX решили оснащать «Blade» процессорами Transmeta Crusoe с низким напряжением питания, применяемыми в ноутбуках. К сожалению, это решение оказалось малоэффективным: по сравнению с обычными стоечными серверами «Blade» проигрывали - были менее мощными и перегревались.

Серверы второго поколения, ServerBlade 667 , появившиеся уже в декабре 2001 г., отличались увеличившейся более чем на 30% производительностью по сравнению с ServerBlade 633. Кроме того, можно было устанавливать в одни и те же шасси «лезвия» и первого, и второго поколений, что упрощало переход на более быстрые «лезвия». Blade-серверы второго поколения, хоть и были, как и их предшественники, укомплектованы низковольтными процессорами Transmeta Crusoe, превосходили их по объему памяти и могли работать с большим числом операционных систем: различными конфигурациями Windows Server 2000 и Red Hat Linux. Еще одно новшество в «Blade`ах» второго поколения компании RLX - отдельные сеть управления «блейдами» и система управления «блэйдами», получившая название RLX Control Tower Blade. Последняя осуществляла мониторинг «блейдов» и управление ими как единой системой, а также по сети предоставляла удаленную консоль к «блейдам». Кроме этого, у системы управления RLX Control Tower Blade был Web-интерфейс, что позволяло администрировать всю систему с меньшими затратами. «Блейды» второго поколения компании RLX использовались для построения Linux-кластеров в таких областях науки, как биоинформатика, сейсмоанализ и вычислительная химия.

В серверах третьего поколения, выпущенных в феврале 2002 г., проблема перегревающихся процессоров была решена: на ServerBlade 800i устанавливался низковольтный 800-МГц процессор Intel Pentium III. При базовой комплектации с 512-Мбайт памятью можно было расширить память до 1 Гбайт, а суммарный объем жестких дисков, оставленных на «лезвиях», мог быть увеличен с 20 до 80 Гбайт. Это поколение, помимо увеличения мощности, отличалось от предыдущего появлением «блейда» нового типа - управляющего. Он играл роль встроенной шины управления, и с его помощью системный администратор мог настраивать порты коммутатора и VLAN из командной строки. Как и серверы второго поколения, ServerBlade 800i был оптимизирован для различных ОС семейств Windows и Linux.

Один из первых Blade-серверов

«Блейды» четвертого поколения - ServerBlade 1200i , появившиеся в сентябре 2002 г., на 50% превосходили предшественников по скорости процессора (комплектовались ЦП Intel Pentium III с частотой 1,2 ГГц и 512-Кбайт кэш-памятью второго уровня), емкости дисковой подсистемы (она еще не была вынесена из «блейдов», максимальная суммарная емкость локальных дисков составила 120 Гбайт) и на 100% по объему памяти (максимум - 2 Гбайт).

В серверах пятого поколения - ServerBlade 2800i , 3000i, выпущенных в марте 2003 г., интересно не только увеличение производительности процессора, объема памяти и дисковых подсистем. Это были первые многопроцессорные «блейды» - они оснащались двумя 2,8-ГГц процессорами Intel Xeon с 512-Кбайт кэш-памятью L2. Кроме того, RLX Technologies стала первой компанией, оснастившей выпускаемые «лезвия» интерфейсными платами Infiniband. Видимо, именно эти два усовершенствования существенно повысили цену: ServerBlade 2800i был вдвое дороже ServerBlade 1200i.

Последнее, шестое поколение «Blade`ов» RLX SB6400 , увидело свет в ноябре 2004 г. Максимальный объем памяти был увеличен до 4 Гбайт, они поддерживали до двух 64-бит процессоров Intel Xeon с тактовой частотой от 2,8 до 3,6 ГГц. В них были интегрированы сетевые интерфейсы Ethernet, Infiniband и Fibrе Channel, а также контроллер PCI Express.

Однако, несмотря на неплохие характеристики новых серверов пионеру Blade-архитектуры пришлось оставить этот рынок. Компания RLX признала, что конкурировать на рынке с такими гигантами, как Sun, HP и Dell, слишком сложно. Она приняла решение свернуть производство «блейдов», ограничив свою деятельность производством управляющего ПО.

3 октября 2005 г. RLX Technologies была куплена компанией HP, которая продолжает выпускать «блейды» RLX, а RLX стала группой технологических решений компании НР.

К 2005 г. Все крупные игроки на рынке серверной техники заинтересовались Blade-серверами и начали выпускать свою технику. Некоторые компании разрабатывали свои решения в области Blade-систем, другие заимствовали существующие решения. Была создана жёсткая конкуренция за рынок Blade-систем. Каждый вендор старался принести своё новшество в «блейды».

Современный Blade-сервер HP ProLiant 460c: более компактный и более экономичный

В настоящее время, к примеру, один Blade-сервер HP ProLiant 460c не уступает в производительности и отказоустойчивости тонкому стоечному серверу HP ProLiant DL360, высотой в 1U. При этом в 1 Blade-шасси HP BladeSystem, высотой в 10U можно вместить 16 серверов HP ProLiant 460c. Таким образом, в стандартную стойку, высотой 42U поместится 42 сервера HP ProLiant DL360 G6 или 4 х 16 = 64 сервера HP ProLiant 460c. В то же время, Blade-серверами легче управлять и администрировать, они будут потреблять меньше электроэнергии, выделяя при этом меньше тепла. Работа обслуживающего персонала сокращается также из-за уменьшения количества кабелей, подходящих к серверной стойке, в разы.

Постепенно Blade-серверы смогли использовать большинство технологий, использующихся в обычных стоечных серверах. Появились полнофункциональные RAID-контроллеры, использующие диски с возможностью горячей замены. «Блейды» поддерживают популярные технологии коммуникаций – сетевые адаптеры и коммутаторы Gigabit Ethernet, оптико-волоконные адаптеры и коммутаторы Fibre Channel, высокоскоростные соединения Infiniband. Сейчас в большинстве блейд-систем отсутствует единая точка отказа – все основные компоненты системы дублированы для отказоустойчивости. А при выходе из строя Blade-сервера, его можно заменить целиком и в короткие сроки восстановить работу.

Вместо Blade-сервера в шасси может быть установлен Blade-накопитель

Последние новинки в мире Blade-серверов включают в себя «Storage-Blade» (storage - хранение), «Tape-Blade» (tape – магнитная лента) и «PCI-Blade». Первые представляют собой лезвия, максимально забитые жёсткими дисками, и по сути являющиеся внешними дисковыми корзинами для обычных «блейдов», установленных в шасси. Вторые являются лезвиями, в форм-фактор которых умещен современный ленточный накопитель. Третьи из перечисленных «блейдов» - это лезвия для установки полноразмерных плат с интерфейсами PCI, PCI-x, или PCI-e. Они созданы для решения проблемы внутренней расширяемости Blade-серверов.

Таким образом, стремясь к консолидации ресурсов, производитель предлагает компаниям единый блок, сочетающий в себе вычислительные ресурсы (Blade-серверы) с возможностями расширения, не уступающими обычным серверам (поддержка нескольких многоядерных процессоров и больших объёмов памяти «блейдами», внутренние mezzanine-платы плюс «PCI-блейды»), системы хранения данных («сторадж-блейды») и устройства резервного копирования («тейп-блейды»).

Эволюция Blade-серверов

|

Функциональные изменения |

Появление новых частей в конструкции |

|

|

Основная функция технической системы – выполнение функций сервера, при компактном размещении в серверной стойке. 1)Blade-серверы в шасси, с вынесенными в общее пользование блоками питания, модулями охлаждения и коммутации; |

Первая Blade-система в мире от RXL Technologies. |

|

| 1) возможность установки больших объёмов оперативной памяти в «лезвия»;

2) возможность установки обычных серверных процессоров в «лезвия»; 3) аппаратное и программное обеспечение для мониторинга и управления лезвиями в шасси; 4) возможность установки в шасси модульных Ethernet-коммутаторов, соединяемых с «блейдами» по внутренней шине. |

Увеличенное количество слотов для установки модулей памяти. Поддержка Blade-серверами обычных серверных процессоров того времени. Управляющий модуль в шасси. Модульные Ethernet-коммутаторы в шасси. |

|

| 1) возможности установки интерфейсов плат расширения Fibre Channel и Infiniband в «блейды», и установки соответствующих коммутаторов в шасси;

2) наличие различных моделей Blade-серверов: от «легких» (по мощности соответствующих персональному компьютеру), до «тяжёлых» (по производительности не уступающих серверам среднего уровня); 3) возможность установки в «лезвия» SCSI-дисков с возможностью горячей замены, использующихся в обычных серверах; 4) возможность установки в «блейды» двуядерных процессоров, адаптированных с обычных серверов. |

Многофункциональные «Mezzanine-слотоы» в «блейдах», поддерживающие Ethernet-, Fibre Channel-, Infiniband-адаптеры. Разные размеры и функциональность блейдов, устанавливаемых в одно шасси. Полнофункциональный RAID-контроллер поддерживающий SCSI-диски и их горячую замену. |

|

| 1) появление Blade-систем без «единой точки отказа» (single point of failure);

2) поставка Blade-шасси с специальной модульной системой охлаждения; 3) появление «блейдов», поддерживающих процессоры AMD Opteron. |

Отказоустойчивые компоненты Blade-системы. Серверная стойка для Blade-шасси с водяным охлаждением. |

|